IA: la (rin)corsa normativa contro la deresponsabilizzazione

L’IA non è più un concetto astratto quanto un’infrastruttura già integrata nei processi quotidiani di aziende, istituzioni e cittadini: dalla selezione del personale alle diagnosi mediche assistite, dalla concessione di credito alla manutenzione predittiva in ambito industriale, i sistemi automatici influenzano le decisioni con conseguenze tangibili.

Diviene pertanto inevitabile porsi una domanda centrale: “chi risponde nel caso in cui l’algoritmo sbagli e provochi un danno a persone o cose?”

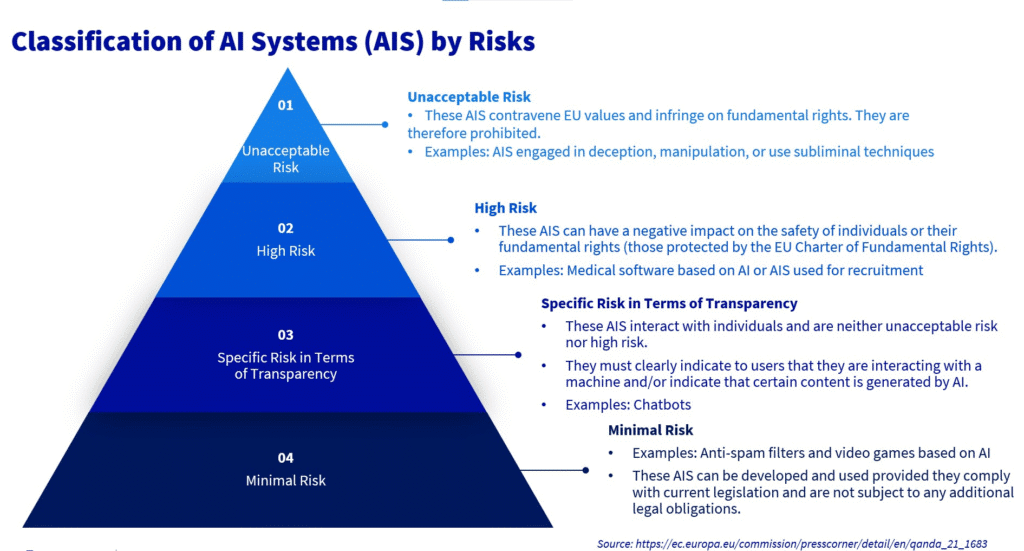

Mediante il Regolamento (UE) 2024/1689, noto come “AI Act”, l’Unione Europea ha posto le basi di un quadro regolatorio che classifica i sistemi a seconda del livello di rischio ed introduce obblighi di trasparenza, monitoraggio, documentazione e sicurezza, in particolare in riferimento a quanto sia destinato ad un utilizzo ad “alto impatto”. La disciplina sulla responsabilità civile resta comunque ad oggi affidata principalmente alla Direttiva (UE) 2024/2853 inerente alla responsabilità per danno da prodotti difettosi, all’interno della quale è stato esteso il concetto di “prodotto” anche al software ed ai suoi aggiornamenti, introducendo presunzioni probatorie[1] e regole precise sulla disponibilità della documentazione tecnica. L’AI Act e la direttiva non hanno effettive sovrapposizioni: il primo stabilisce i requisiti di corretto funzionamento, la seconda individua chi risponda in caso di difetto (e, per estensione, in caso di non rispondenza alle specifiche od alle procedure e raccomandazioni del caso).

Prima ancora che giuridico, il rischio di deresponsabilizzazione è di natura comportamentale: gli studi sull’interazione uomo-macchina mostrano come l’essere umano tenda a fidarsi troppo delle decisioni automatizzate, specialmente allorquando non possieda le competenze per valutare criticamente l’output del sistema. Il fenomeno, definito “sovra-affidamento”[2], porta a validare in modo acritico suggerimenti e valutazioni dell’algoritmo, anche quando vi siano indizi di errore. Al contrario, quando emerge un malfunzionamento evidente, la fiducia crolla e difficilmente si ricostruisce. Entrambe le reazioni sono distorsioni che riducono la capacità di controllo ed aumentano il rischio di errori operativi ed impatti sui terzi. Spesso, la cosiddetta “sorveglianza umana” si riduce, inoltre, ad un adempimento formale: l’operatore firma od approva senza poter realmente modificare o bloccare il processo, a causa della mancanza di strumenti o di tempo. Non a caso l’AI Act ha imposto che la supervisione non sia solo simbolica quanto sostanziale, supportata da registri verificabili e dalla capacità concreta di intervenire: in assenza di tali garanzie, il rischio è che la responsabilità si disperda, lasciando le vittime prive di tutela.

La catena delle responsabilità risulta tanto più complessa quanto più articolata sia la filiera dell’IA: lo sviluppo del modello, l’integrazione nella soluzione, la messa in servizio e l’uso operativo sono fasi che coinvolgono soggetti differenti. Il diritto europeo ha scelto per tale ragione un approccio a più livelli: il regolamento sull’IA impone obblighi di gestione del rischio, controllo dei dati, registrazione delle attività e capacità di intervento umano, soprattutto per i sistemi ad alto rischio e per i modelli ad uso generale con rilevanza sistemica. Siffatti obblighi non equivalgono ad una disciplina della colpa[3], bensì fissano doveri tecnici che, qualora ignorati, diventino elementi decisivi in sede di giudizio. La direttiva sulla responsabilità per prodotti difettosi, di converso, prevede un regime oggettivo: nel caso in cui il software sia difettoso e causi un danno, il produttore ne risponde anche in assenza di colpa. Sono previste presunzioni probatorie a tutela della parte danneggiata, tra cui quella che scatta qualora il produttore rifiuti di fornire la documentazione tecnica richiesta, oppure quando non abbia garantito aggiornamenti di sicurezza.

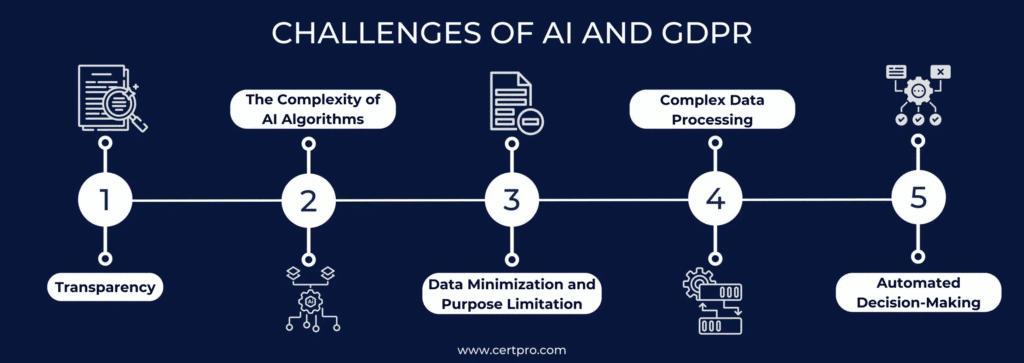

A ciò si aggiunge il quadro del “Regolamento generale sulla protezione dei dati”: l’articolo 22 vieta le decisioni basate unicamente su processi automatizzati che abbiano effetti giuridici o conseguenze significative sugli individui, se non in presenza di garanzie adeguate. Le pronunce della Corte di giustizia dell’Unione europea hanno rafforzato il principio: il caso SCHUFA del 2023 ha chiarito che uno “scoring” (punteggio) di credito[4] è esso stesso una decisione, mentre il caso Dun & Bradstreet del 2025 ha ribadito come i segreti commerciali non possano impedire al cittadino di ottenere spiegazioni comprensibili riguardo alla logica di valutazioni che incidano sui propri diritti.

Accanto al tema giuridico si pone quello, altrettanto decisivo, della sicurezza informatica: molti incidenti che coinvolgono sistemi di intelligenza artificiale non derivano da errori concettuali del modello, ma da vulnerabilità trascurate, da mancate correzioni di difetti noti o da manipolazioni intenzionali lungo la catena di fornitura del software. In simili casi non ha senso parlare di “colpa della macchina”: la responsabilità resta di chi non abbia adottato misure minime di protezione. La direttiva europea NIS2 ha introdotto obblighi di gestione del rischio e notifica degli incidenti per i soggetti considerati essenziali od importanti, mentre l’Agenzia europea per la cybersicurezza (ENISA) ha pubblicato raccomandazioni operative e quadri tecnici di riferimento per rafforzare la protezione dei sistemi di IA. In mancanza di aggiornamenti tempestivi o di controlli sui fornitori, difficilmente un giudice accetterebbe che il danno sia stato imprevedibile od inevitabile (assenza di idonea diligenza[5]).

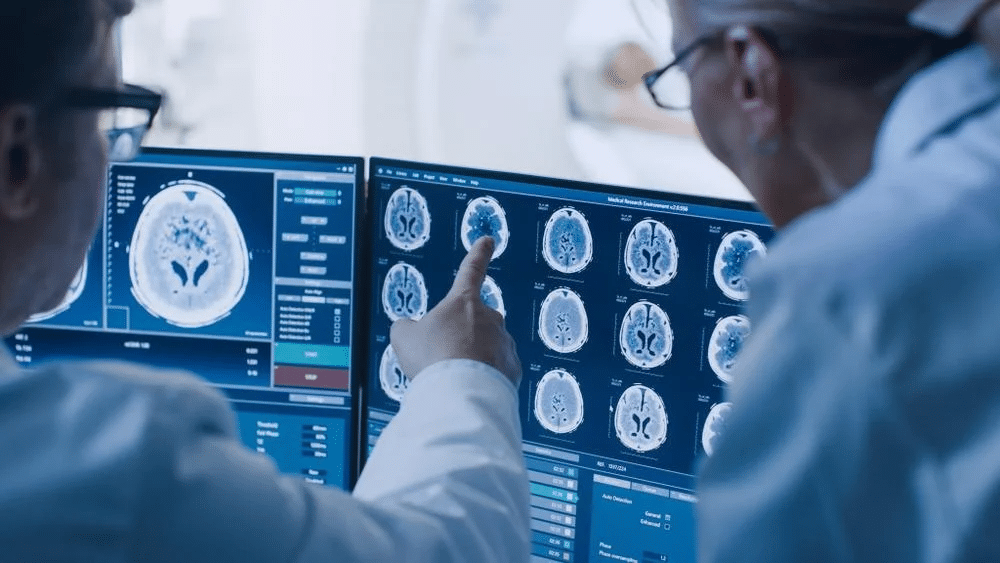

Particolarmente significativo è l’ambito sanitario, che costituisce una sorta di cartina al tornasole per comprendere come le istituzioni affrontino i rischi legati all’uso dell’IA. Negli Stati Uniti, l’FDA ha introdotto nel 2024 linee guida vincolanti sui piani di modifica pre-autorizzati dei dispositivi medici basati su IA: ogni evoluzione dell’algoritmo deve essere prevista, documentata ed autorizzata prima della sua implementazione. In Europa, il gruppo di coordinamento sui dispositivi medici (MDCG) ha aggiornato nel 2025 il documento 2019-11, precisando i criteri di classificazione e qualificazione del software, con attenzione specifica alle intersezioni con il nuovo AI Act. Simili esempi dimostrano come, soprattutto in contesti critici, la tracciabilità delle modifiche non sia solo una buona pratica quanto un vero e proprio obbligo, e che, in mancanza di documentazione adeguata, la responsabilità dei produttori divenga difficilmente contestabile.

Ulteriore nodo è quello inerente alla documentazione dei processi: dichiarare che un sistema sia sicuro non basta; occorre poterlo dimostrare mediante registri, schede tecniche, tracciamento delle versioni e conservazione delle decisioni adottate. Senza le relative prove, la ricostruzione causale diventa impossibile ed il diritto europeo prevede che la mancanza di documentazione generi presunzioni a carico del produttore. Ciò rende indispensabile che le imprese organizzino processi di gestione della documentazione robusti e che nei rapporti contrattuali con i fornitori siano inserite clausole specifiche di cooperazione e trasparenza, così da non trovarsi senza strumenti in caso di contenzioso. Anche gli standard volontari, quali la norma ISO/IEC 42001:2023 sul sistema di gestione per l’IA, possono aiutare a strutturare governance e controlli, ma non costituiscono un’esenzione dalla responsabilità: rappresentano piuttosto un mezzo atto a dimostrare di aver adottato una condotta diligente ed organizzata.

Emerge pertanto con chiarezza come l’IA non annulli la responsabilità umana, ma la ridefinisca e la distribuisca in modo inedito: oggi esistono strumenti normativi e tecnici per evitare che l’IA diventi un alibi, scaricando sugli algoritmi colpe che restano invece a carico degli operatori, dei produttori e dei gestori dei sistemi. La sfida per imprese ed istituzioni non è quella di frenare l’innovazione, bensì evitare che essa produca danni senza rimedio, attraverso la costruzione di processi trasparenti, documentati e controllabili: in tal modo, l’IA potrà essere davvero un motore di progresso e non una zona grigia dove nessuno risponda delle conseguenze delle scelte automatizzate.

Riferimenti bibliografici:

- Corte di giustizia dell’Unione europea. (2023). C-634/21, OQ v. Land Hessen (SCHUFA). Testo ufficiale su EUR-Lex:

https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:62021CJ0634 - Corte di giustizia dell’Unione europea. (2025). C-203/22, Dun & Bradstreet Austria GmbH. (Comunicato stampa n. 22/25).

Disponibile su CURIA:

https://curia.europa.eu/jcms/jcms/p1_4811088/fr/ - ENISA. (2024). Multilayer framework for good cybersecurity practices for AI.

Pubblicazione ufficiale:

https://www.enisa.europa.eu/publications/multilayer-framework-for-good-cybersecurity-practices-for-ai - ENISA. (2025). NIS2 Technical Implementation Guidance.

Guida tecnica (PDF):

https://www.enisa.europa.eu/sites/default/files/2025-06/ENISA_Technical_implementation_guidance_on_cybersecurity_risk_management_measures_version_1.0.pdf - European Parliament. (2025). AI Liability Directive — Withdrawal (Legislative Train). Scheda sul sito ufficiale:

https://www.europarl.europa.eu/legislative-train/theme-a-europe-fit-for-the-digital-age/file-ai-liability-directive - FDA. (2024). Marketing Submission Recommendations for a Predetermined Change Control Plan for AI-Enabled Device Software Functions (Final Guidance).

Documento ufficiale:

https://www.fda.gov/regulatory-information/search-fda-guidance-documents/marketing-submission-recommendations-predetermined-change-control-plan-artificial-intelligence - ISO/IEC. (2023). ISO/IEC 42001:2023 — Artificial intelligence — Management system. Scheda ufficiale ISO:

https://www.iso.org/standard/42001.html - NIST. (2023). AI Risk Management Framework (AI RMF 1.0).

Documento ufficiale (PDF):

https://nvlpubs.nist.gov/nistpubs/ai/nist.ai.100-1.pdf - NIST. (2024). Artificial Intelligence Risk Management Framework: Generative Artificial Intelligence Profile (NIST AI 600-1).

DOI ufficiale:

https://doi.org/10.6028/NIST.AI.600-1 - Unione europea. (2016). Regolamento (UE) 2016/679 (GDPR).

Testo ufficiale su EUR-Lex:

https://eur-lex.europa.eu/eli/reg/2016/679/oj - Unione europea. (2022). Direttiva (UE) 2022/2555 (NIS2).

Testo ufficiale su EUR-Lex:

https://eur-lex.europa.eu/eli/dir/2022/2555/oj - Unione europea. (2024). Regolamento (UE) 2024/1689 (AI Act).

Testo ufficiale su EUR-Lex:

https://eur-lex.europa.eu/eli/reg/2024/1689/oj - Unione europea. (2024). Direttiva (UE) 2024/2853 sulla responsabilità per i danni causati da prodotti difettosi.

Testo ufficiale su EUR-Lex:

https://eur-lex.europa.eu/eli/dir/2024/2853/oj

Note:

[1] La presunzione probatoria è un meccanismo giuridico che consente di considerare provato un fatto sulla base di un’altra circostanza stabilita dalla legge, salvo che venga fornita prova contraria.

[2] Per sovra-affidamento si intende la tendenza dell’utente umano a riporre eccessiva fiducia nelle decisioni o nei suggerimenti forniti da un sistema automatizzato.

[3] Con disciplina della colpa si indica l’insieme delle norme che regolano la responsabilità civile o penale di un soggetto quando un danno deriva da comportamento negligente, imprudente od imperito, distinto dalla responsabilità oggettiva che prescinde invece dall’accertamento della colpa.

[4] Lo scoring di credito è la valutazione numerica o di categoria, generata da modelli statistici od algoritmici, che stima l’affidabilità finanziaria di una persona o di un’impresa e viene utilizzata per decidere l’accesso a prestiti, mutui od altri servizi finanziari.

[5] L’assenza di idonea diligenza, nel contesto della normativa europea sull’IA, si riferisce al mancato rispetto degli obblighi di cura, controllo e prevenzione che un operatore (fornitore, distributore o utilizzatore) è tenuto ad adottare per garantire sicurezza, trasparenza ed affidabilità del sistema.