La guerra della mente

L’incontro tra IA (intelligenza artificiale), cyberwarfare e bias cognitivi sta trasformando i conflitti contemporanei in battaglie dove il bersaglio non è solo l’infrastruttura, quanto la percezione. La superficie d’attacco oggi include piattaforme sociali, motori di ricerca, app di messaggistica e sistemi di identità digitale; i “vettori” sono messaggi, immagini e voci sintetiche; l’effetto finale si traduce in decisioni individuali e collettive piegate da scorciatoie mentali che tutti utilizziamo.

Lo scenario

L’IA gioca il ruolo di moltiplicatore: rende più economici, veloci e credibili gli attacchi informativi e di social-engineering[1], trasformando le stesse fragilità cognitive che ci aiutano a decidere in fretta in punti di pressione per governi, gruppi criminali e “mercenari dell’influenza”. È la “cognitive warfare”, dove — per usare le parole della NATO —

«la mente umana diventa il campo di battaglia»

I numeri spiegano perché. Il Data Breach Investigations Report 2024 di Verizon mostra come gli attacchi di social engineering siano cresciuti in modo significativo e, guardando l’intero dataset (insieme di dati) “senza errori”, passano dal 29% al 45% dei breach[2]; ancora più allarmante è la dinamica temporale: il tempo mediano per cliccare un link malevolo dopo l’apertura è di 21 secondi e sono necessari solo altri 28 secondi per inserire le credenziali. In altre parole,

«il tempo mediano per cadere in un’email di phishing[3] è meno di 60 secondi».

L’aumento dei BEC (business e-mail compromise, compromissione delle e-mail aziendali) conferma la macro-tendenza, registrando importi mediani intorno ai 50 mila dollari per singola truffa.

Sul fronte informativo, i social rimangono un canale cruciale per l’accesso alle notizie. Pew Research Center rileva che il 54% degli adulti statunitensi dice di ottenere almeno saltuariamente notizie dai social; Facebook e YouTube sono le piattaforme più frequenti per l’uso “regolare” quali fonti di news. Tra i giovani cresce anche TikTok (dal 3% nel 2020 al 17% nel 2024), mentre circa uno su cinque dichiara di informarsi regolarmente tramite “news influencers”[4] (2024). Tali comportamenti non restano confinati agli USA ed influenzano anche l’ecosistema europeo, come mostrano i Digital News Reports del Reuters Institute.

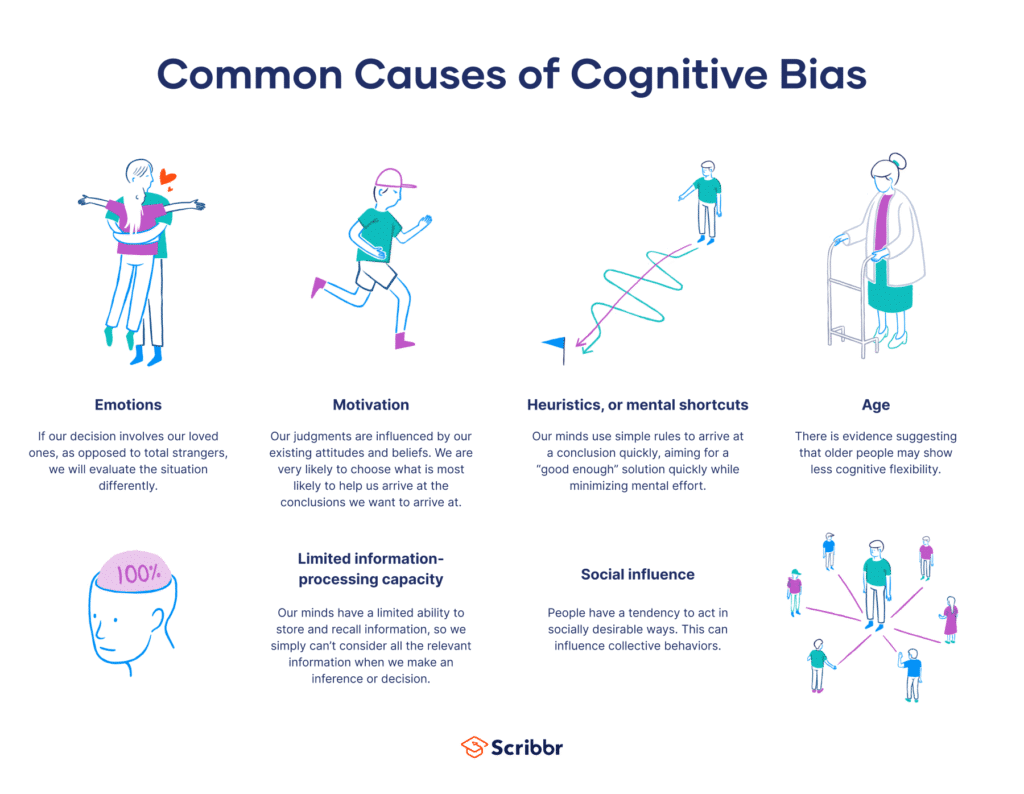

Cosa sono i bias cognitivi

I bias cognitivi sono scorciatoie mentali (heuristics[5]) che riducono lo sforzo decisionale ma che comportano problematiche. La descrizione classica di Tversky e Kahneman rimane attuale:

«Queste euristiche sono altamente economiche e di solito efficaci, ma portano ad errori sistematici e prevedibili».

Nel contesto informativo-digitale diverse famiglie di bias risultano particolarmente sfruttabili.

Bias di conferma. È la tendenza a cercare, interpretare e ricordare le informazioni coerenti con le nostre convinzioni. Nickerson lo definisce un fenomeno “ubiquitario”, che “sussume” molte varianti motivate e non motivate. Applicato al feed social, spinge a cliccare e condividere contenuti allineati alla nostra identità, riducendo la soglia critica verso affermazioni false ma plausibili.

Disponibilità. Stimiamo la frequenza o la probabilità di un evento in base alla facilità con cui esempi simili ci vengano in mente. In una “dieta mediatica” dominata da contenuti virali e breaking news, incidenti di fatto rari possono apparire come comuni, alterando priorità e percezione del rischio; l’IA amplifica tale fenomeno generando rapidamente contenuti “memorabili”. La letteratura sulle heuristics colloca il fenomento tra i capisaldi delle distorsioni del giudizio.

Ancoraggio. Un valore iniziale — anche casuale — condiziona le stime successive: in presenza di numeri e condizioni al contorno iniziali, gli aggiustamenti si rivelano sistematicamente insufficienti. In campagne di disinformazione, una cifra iniziale o un “falso scoop” piantano un paletto che orienta la narrativa successiva, anche a seguito di successive smentite.

Ragionamento pigro. Un filone sperimentale rileva come la scarsa attivazione del pensiero analitico spieghi più della polarizzazione ideologica la suscettibilità alle notizie false; in altre parole, siamo spesso “lazy, not biased” (pigri, non polarizzati) quando abbocchiamo a notizie false. Per l’operatore ostile ciò significa che distrazione, fretta e sovraccarico siano leve più efficaci dell’argomentazione sofisticata ed artefatta.

Come l’IA attiva i bias

Le tecniche di cyber-influence[6] e social engineering oggi si appoggiano su modelli generativi al fine di personalizzare messaggi, moltiplicare la produzione di contenuti ed imitare stili lessicali o voci umane. L’IA consente phishing su misura che sfrutta ancoraggi (“urgenza” mediante contenuti verosimili), disponibilità (ripetizione di immagini shock), conferma (microtargeting su cluster ideologici, ovvero personalizzazione dei contenuti in base al profilo socioculturale entro il quale è stato catalogato il singolo utente). Il Microsoft Digital Defense evidenzia la crescita di attori e segnali: la telemetria quotidiana si misura in decine di trilioni di segnali e centinaia di milioni di attacchi bloccati al giorno, nonché oltre 1.500 gruppi di minaccia tracciati; nel capitolo su “Protecting democracies” Microsoft documenta come l’IA sia sempre più usata per rendere più credibili truffe e operazioni d’influenza.

Sul versante europeo, ENISA Threat Landscape 2024 rileva un uso crescente dell’IA generativa per abbassare la barriera d’ingresso e migliorare la qualità di contenuti manipolativi e campagne di social-engineering, seppur notando come l’impatto operativo vari per settore e maturità difensiva. L’EEAS (Servizio europeo per l’azione esterna) nel 3° Rapporto su FIMI (marzo 2025) descrive arsenali digitali su larga scala, in particolare russi e cinesi, progettati per operazioni di influenza e manipolazione informativa cross-piattaforma.

Sulle piattaforme social, la componente umana resta il fattore critico. Il DBIR 2024 riporta che il pretexting[7] — spesso ad esito BEC — costituisce circa un quarto degli attacchi a fini finanziari, mentre per il phishing bastino meno di 60 secondi affinché una vittima media cada nella trappola. In parallelo, l’uso dei social come fonte di notizie crea il contesto perfetto affinché contenuti ottimizzati dall’IA incontrino utenti già predisposti dai loro bias — il 54% di adulti negli USA dichiara di informarsi almeno a volte dai social, quota che cresce con tra i più giovani.

Dalle prove di laboratorio ai casi reali

Gli esperimenti del NATO StratCom COE mostrano quanto sia rapido, economico ed efficace acquistare manipolazione commerciale: con appena €300 i ricercatori hanno comprato 54.380 interazioni non autentiche (commenti, like, visualizzazioni, follower), identificando 18.739 account utilizzati per l’operazione. Non si tratta di teoria: è il mercato grigio che alimenta le campagne di amplificazione e semina “prove sociali” fasulle, sfruttando l’euristica della disponibilità e l’ancoraggio numerico (da cui, note quali: “questo post ha migliaia di like”).

I casi di deepfake[8] offrono un’anteprima di quella che si preannuncia essere la “nuova normalità”. Nel 2024 un robocall[9] con voce sintetica attribuita a Joe Biden ha cercato di dissuadere gli elettori dal votare alle primarie del New Hampshire; l’FCC (la Commissione Federale per le Comunicazioni) ha successivamente comminato una sanzione da 6 milioni di dollari al consulente politico coinvolto. Nel 2023 in Slovacchia un audio deepfake pubblicato a ridosso del silenzio elettorale ha insinuato una cospirazione per “truccare” il voto, rendendo difficilissimo il fact-checking[10] tempestivo. Contestualmente, alcune ricerche indipendenti del Turing Institute ed analisi sulle elezioni europee del 2024 indicano che l’impatto misurabile dei deepfake sui risultati è stato finora limitato, pur restando alto il potenziale di rischio sistemico. Un doppio dato che invita ad evitare sia allarmismi che compiacenze: la minaccia esiste e migliora e si amplia con l’IA, ma la resilienza sociale conta e ha ancora un notevole peso.

Micro-targeting, identità ed “ingegneria del contesto”

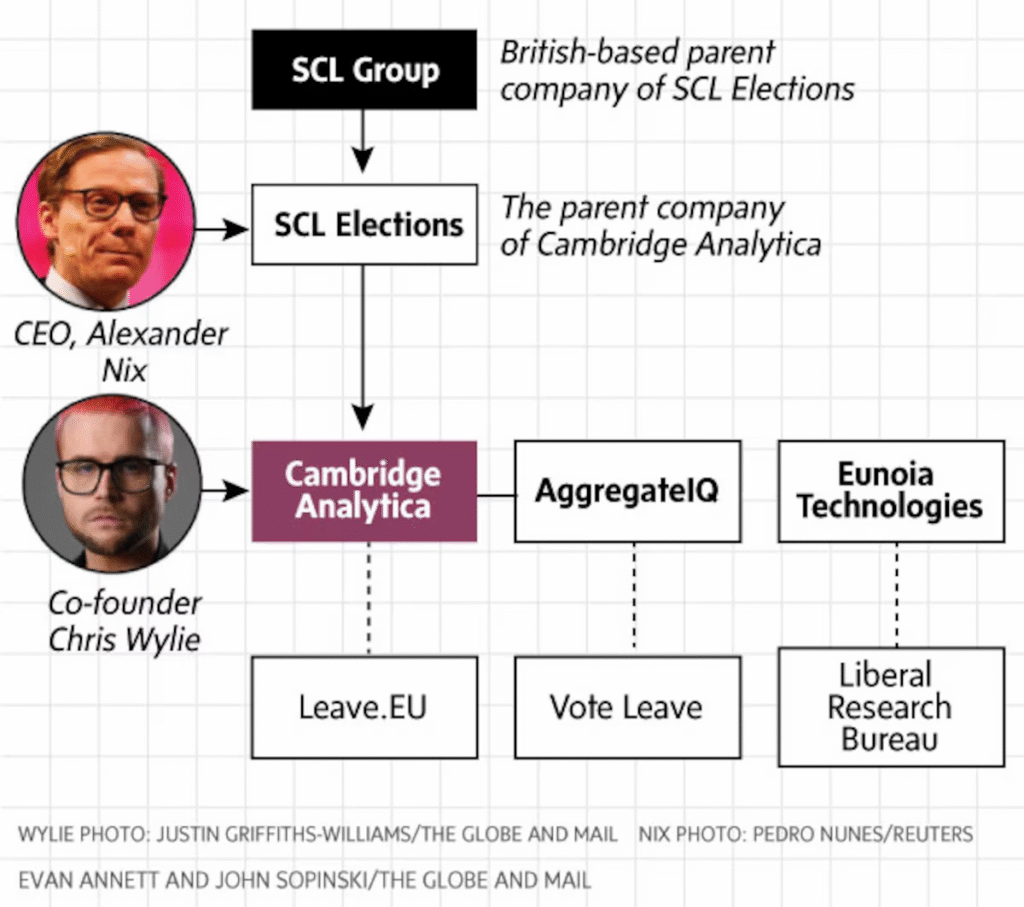

Il micro-targeting politico vive della selezione e combinazione di dati personali, preferenze e segnali comportamentali per colpire bias specifici. La vicenda Cambridge Analytica ha spinto autorità e legislatori ad indagare e regolamentare l’ ecosistema: i rapporti dell’ICO (Information Commissioner’s Office) britannico e le risoluzioni del Parlamento europeo hanno documentato l’uso improprio dei dati di milioni di utenti e delineato linee guida sulla profilazione in ambito elettorale. Il principio di fondo viene confermato: “più dettagliato è il profilo, più preciso è l’innesco dei nostri automatismi cognitivi”.

A livello psicologico, attenzione e carico cognitivo pesano quanto l’ideologia: la letteratura empirica suggerisce come il migliorare l’attivazione del pensiero analitico riduca la suscettibilità al falso, indipendentemente dall’orientamento politico. «La nostra evidenza suggerisce che la suscettibilità alle fake news è dovuta più al pensiero pigro che al pregiudizio partigiano in sé», scrivono Pennycook & Rand. È esattamente lo spazio che l’IA offensiva sfrutta: messaggi goccia-a-goccia, iper-personalizzati, temporalmente opportuni, che riducono il tempo per riflettere e favoriscono click impulsivi.

Come difendersi

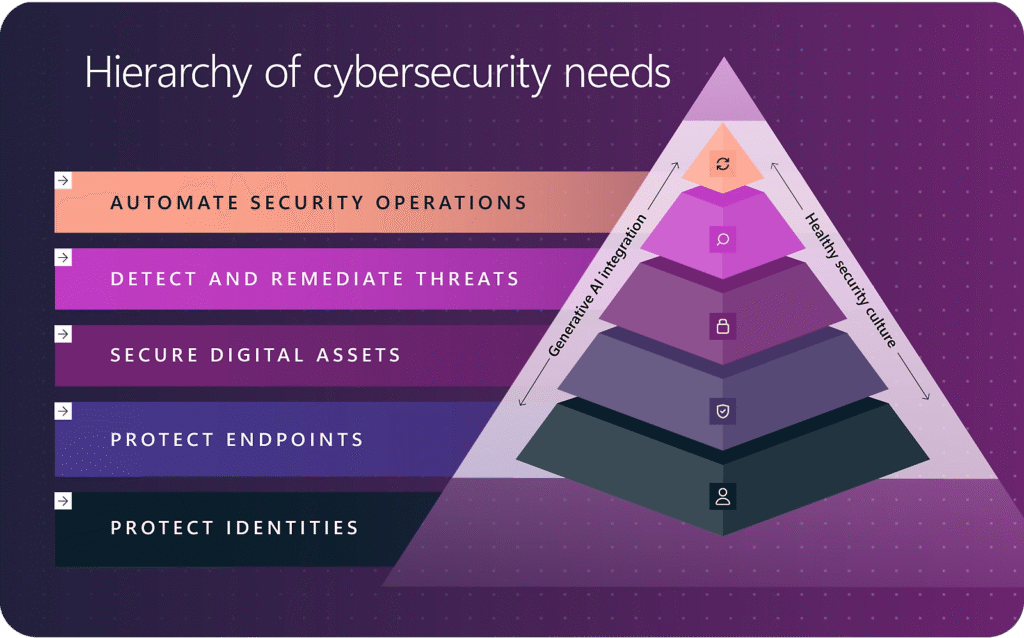

La difesa non è solo tecnologica: serve una combinazione di igiene digitale ed igiene cognitiva.

Dal lato tecnico, l’adozione diffusa di MFA (multi-factor authentication, autenticazione a più fattori), protezione delle identità e monitoraggio comportamento-centrico riduce l’efficacia del pretexting e del credential theft (furto d’identità). I grandi ecosistemi di sicurezza — come quello di Microsoft, che raccoglie ed analizza enormi quantità di dati e blocchi su vasta scala — sono fondamentali, ma non sufficienti allorquando l’utente, in meno di un minuto, cada vittima di un inganno.

Sul piano umano risultano più efficaci forme di formazione brevi e ricorrenti contro il phishing, strategie preventive che preparino a riconoscere le manipolazioni, nonché momenti di “pausa consapevole” nei processi decisionali più delicati, quali ad esempio i bonifici bancari. Tra gli strumenti utili vanno inoltre considerate la trasparenza degli algoritmi, l’etichettatura dei contenuti generati artificialmente e la verifica indipendente delle filiere di pubblicità politica, come già raccomandato da ENISA, dal Servizio europeo per l’azione esterna e dal Parlamento europeo.

Citazioni:

- «These heuristics are highly economical and usually effective, but they lead to systematic and predictable errors.» — Tversky & Kahneman, Science (1974).

https://sites.socsci.uci.edu/~bskyrms/bio/readings/tversky_k_heuristics_biases.pdf - «The median time for users to fall for phishing emails is less than 60 seconds.» — Verizon DBIR 2024, Executive Summary, p. 7–8.

https://www.verizon.com/business/resources/reports/2024-dbir-executive-summary.pdf - «In cognitive warfare, the human mind becomes the battlefield.» — NATO Review (2021).

https://www.nato.int/docu/review/articles/2021/05/20/countering-cognitive-warfare-awareness-and-resilience/index.html

Riferimenti bibliografici:

- NATO. (2021, May 20). Countering cognitive warfare: Awareness and resilience. NATO Review.

https://www.nato.int/docu/review/articles/2021/05/20/countering-cognitive-warfare-awareness-and-resilience/index.html - Verizon. (2024). Data Breach Investigations Report — Executive Summary (pp. 7–8).

https://www.verizon.com/business/resources/reports/2024-dbir-executive-summary.pdf - Pew Research Center. (2024). Social media and news fact sheet.

https://www.pewresearch.org/journalism/fact-sheet/social-media-and-news-fact-sheet/ - Tversky, A., & Kahneman, D. (1974). Judgment under uncertainty: Heuristics and biases. Science, 185(4157), 1124–1131. https://doi.org/10.1126/science.185.4157.1124

- Nickerson, R. S. (1998). Confirmation bias: A ubiquitous phenomenon in many guises. Review of General Psychology, 2(2), 175–220.

https://pages.ucsd.edu/~mckenzie/nickersonConfirmationBias.pdf - Kahneman, D., Slovic, P., & Tversky, A. (1982). Judgment under uncertainty: Heuristics and biases. Cambridge University Press.

- Pennycook, G., & Rand, D. G. (2018). Lazy, not biased: Susceptibility to partisan fake news is better explained by lack of reasoning than by motivated reasoning. Cognition. SSRN preprint.

https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3165567 - Microsoft. (2024). Protecting democracies from cyber-influence. In Microsoft Digital Defense Report 2024.

https://www.microsoft.com/en-us/security/blog/microsoft-digital-defense-report/ - ENISA. (2024). ENISA Threat Landscape 2024. European Union Agency for Cybersecurity.

https://www.enisa.europa.eu/topics/threats-and-trends/threat-landscape/ - NATO StratCom COE. (2022). Social Media Manipulation 2021/2022: The Black Market for Social Media Manipulation (update). NATO StratCom Centre of Excellence.

- Federal Communications Commission. (2024, September 26). Notice of Apparent Liability — AI-generated robocalls mimicking President Biden. https://docs.fcc.gov/public/attachments/DOC-405811A1.pdf

- Wired. (2023, Sept. 28). Slovakia’s election deepfakes show AI is a danger to democracy.

https://www.wired.com/story/slovakias-election-deepfakes-show-ai-is-a-danger-to-democracy/ - Alan Turing Institute. (2024, Sept. 19). No evidence that AI disinformation or deepfakes impacted UK, French or European elections results.

https://www.turing.ac.uk/news/no-evidence-ai-disinformation-or-deepfakes-impacted-uk-french-or-european-elections-results - Information Commissioner’s Office (ICO). (2018, Nov. 6). Investigation into the use of data analytics in political campaigns — Final report.

https://ico.org.uk/media2/migrated/2260271/investigation-into-the-use-of-data-analytics-in-political-campaigns-final-20181105.pdf

Note:

[1] Per social engineering si intende l’insieme di tecniche di manipolazione psicologica volte a indurre una persona a rivelare informazioni riservate, compiere azioni o concedere accessi non autorizzati, sfruttando la fiducia, la disattenzione o l’urgenza piuttosto che vulnerabilità tecniche.

[2] Con il termine breach si indicano incidenti di sicurezza confermati che abbiano comportato l’accesso a dati da parte di persone non autorizzate.

[3] Il phishing è la tecnica di frode informatica con cui un malintenzionato si finge un ente affidabile (banca, azienda, servizio online) per indurre la vittima a rivelare dati sensibili, quali password, codici od informazioni finanziarie, spesso tramite e-mail, SMS o siti web contraffatti.

[4] Il news influencer è un soggetto, spesso attivo su social media o piattaforme digitali, che contribuisce a diffondere, commentare od orientare la percezione delle notizie, influenzando l’opinione pubblica ed il dibattito su temi di attualità.

[5] Con heuristics si designano le regole pratiche o le strategie semplificate che permettano di prendere decisioni o risolvere problemi in modo rapido ed efficace, pur senza garantire la soluzione ottimale.

[6] La cyber-influence è l’insieme di tecniche e strategie digitali volte ad orientare opinioni, comportamenti o decisioni di individui e comunità attraverso l’uso di piattaforme online, social media, algoritmi e contenuti mirati, spesso con finalità politiche, commerciali o di manipolazione informativa.

[7] Con pretexting si indica la tecnica di ingegneria sociale in cui un malintenzionato crea un pretesto credibile (ad es. fingendosi una figura autorevole od un ente legittimo) per indurre una vittima a rivelare informazioni riservate od a compiere azioni che normalmente non farebbe.

[8] Il deepfake è la tecnica basata sull’IA che permette di creare od alterare contenuti audiovisivi (soprattutto volti e voci) in modo realistico, mostrando persone mentre dicono o fanno cose in realtà mai accadute. Spesso usata a fini creativi o di intrattenimento, può però comportare seri rischi di disinformazione, frodi o violazioni della privacy.

[9] Il robocall è la chiamata telefonica automatizzata effettuata da un sistema informatico che riproduce un messaggio preregistrato o generato artificialmente, usata per finalità commerciali, informative o fraudolente.

[10] Con fact-checking si intende l’attività di verifica della veridicità e dell’accuratezza di informazioni, dichiarazioni o notizie, svolta confrontando le fonti ed i dati disponibili per contrastare errori, distorsioni o falsità.