Innocenti vittime de “l’algoritmo”

Come la troppa confidenza nei sistemi di intelligenza artificiale, causi insensati episodi di “censura preventiva”.

Ogni storia narra di eventi e ha i suoi protagonisti.

La storia di oggi, seppur tristemente reale e non frutto di distopica visione, ha tra i suoi protagonisti personaggi non umani. Ma andiamo per ordine.

Il contesto

Il gruppo META, meglio conosciuto nelle sue nomenclature social con le declinazioni di Facebook, Instagram, WhatsApp ed altro ancora, perseguendo la (lecita, benintesi) ricerca del massimo profitto è incorsa nella crescente “deumanizzazione” dei propri servizi. Ebbene, nel commercio, ma ben di più nel rispetto dell’incomparabile valore dell’essere umano, il fine NON giustifica i mezzi.

Incurante di ciò, il gruppo, nell’adottare legittimamente come propria base costitutiva i progressi scientifico-tecnologici (che rappresentano componente essenziale di una moderna società di servizi su scala mondiale), ha ceduto alla tentazione di prevaricare l’essere umano con sistemi artificiali, per l’esattezza di Intelligenza Artificiale (IA).

Quest’ultima, su cui son state spese probabilmente già fin troppe parole, costituisce una delle pietre miliari dell’innovazione tecnologica degli ultimi decenni, rappresenta un validissimo alleato in numerose attività altrimenti ripetitive e degradanti, consente di velocizzare e semplificare compiti prima eccessivamente lunghi e complessi.

Ma nasconde anche insidie subdole ed estremamente pericolose.

Quella del caso in esame è nota agli addetti del settore come “over-reliance”, ovvero “eccesso di confidenza (affidamento, n.d.a.) o di fiducia in qualcuno o in qualcosa”. Nello specifico, nel campo dell’IA significa che chi utilizzi in prima persona od adotti verso terzi quanto il sistema abbia da offrire, ceda alla tentazione di elevare il sistema non più ad integrazione ed ausilio dell’attività umana, bensì come suo sostituto.

Non si tratta, al di là del nome, di “sistemi pensanti”, ovviamente, la realtà è ben lontana dagli scenari apocalittici che alcuni romanzi od alcuni film hanno “profetizzato”, in cui l’umanità sia soggiogata, quando non sterminata, da dispositivi cibernetici in grado di diventare “autocoscienti” e giudicarci come “imperfetti” e come tali “inutili e dannosi”.

Nel contesto specifico, non sono nemmeno i sistemi di IA stessi il problema, bensì il modo in cui l’uomo, proprio colui che in virtù dell’autoconservazione debba tendere alla propria salvaguardia come valore universale, decida di programmarli ed usarli e si dimostri invece, una volta di più, incurante delle proprie scelte.

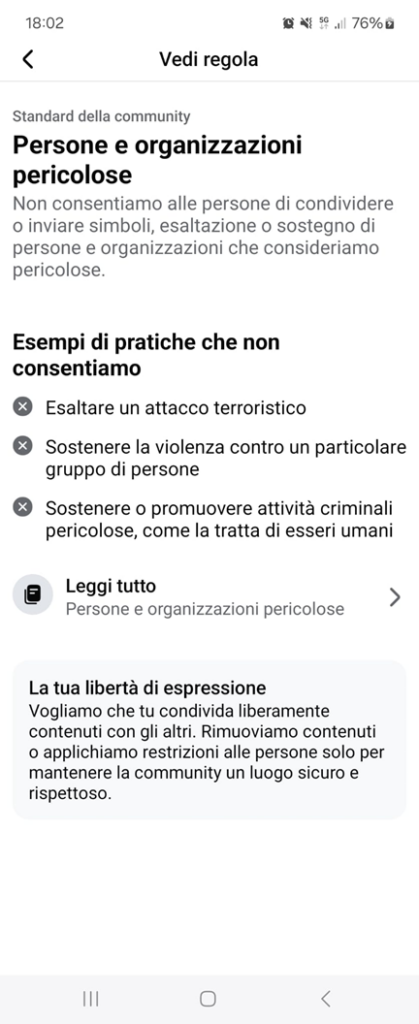

Accade quindi che il gruppo META abbia optato per utilizzare sistemi di IA (che chiameremo per semplicità “l’algoritmo”) finalizzati a decidere se un contenuto postato da un utente su uno dei propri social abbia contenuti pericolosi o meno, di fatto se sia “giusto” o “sbagliato”. E, se già ciò sia bastevole di indurre comprensibile orrore in chi legga, non viene operato nemmeno usando “lo stato dell’arte” delle potenzialità dell’IA, che è ad oggi in grado di avere una discreta comprensione del linguaggio naturale umano e del contesto in cui siano usate le singole parole. No, il sistema “censorio” di META si basa su una rozza e disdicevole individuazione di un insieme di parole che “qualcuno” ha deciso siano “pericolose”, al loro conteggio ed alla rimozione preventiva del “post” all’interno del quale sono state inserite.

Una parola quale “terrorismo” è posta sotto l’attenzione del “l’algoritmo” e, se ciò possa sembrare da un certo punto di vista “logico”, dall’altro una qualunque discussione sulla necessità di sensibilizzazione sul tema può essere erroneamente interpretata come incitazione al medesimo e subire la “scure censoria”.

Mi correggo: non può… lo è!

Il caso

In data 10 gennaio 2025, l’analista geopolitica Arianne Ghersi[1] pubblica sul blog “Caput Mundi” un ottimo articolo in cui compie un’interessante analisi della narrativa “araba” riguardo al terrorismo, focalizzandosi su eventi storici e principi antropologici.

Come suo consueto, nell’intento di divulgare il proprio contenuto, decide di creare un post su Facebook in cui inserisce il collegamento al medesimo articolo. Passano le ore, il suo lavoro riceve i meritati consensi (sia in termini di apprezzamenti espliciti che in numero di visualizzazioni) finché una notifica sul medesimo social la avvisa che il suo contenuto è stato rimosso.

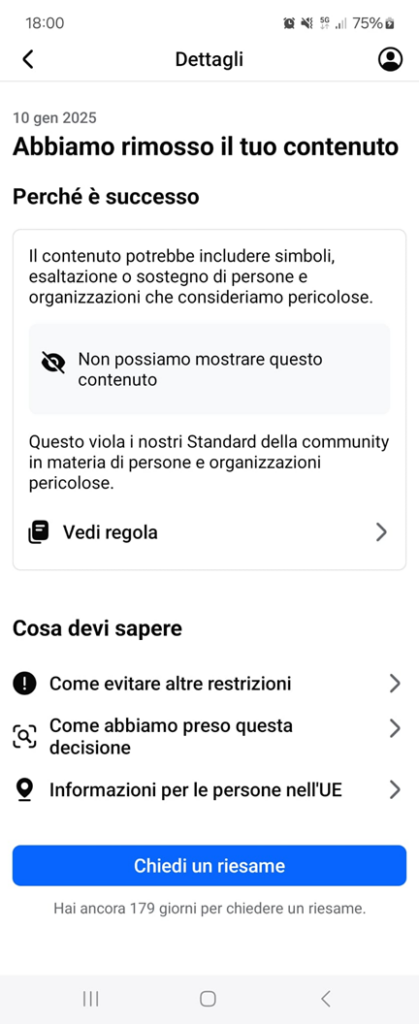

Stupita e disorientata dall’accaduto, cerca spiegazioni tra “gli addetti ai lavori”. Le chiedo di condividermi quanto presente a schermo e ricevo quanto segue:

|  |

Osservo le immagini e mi è sufficiente una rapida occhiata per commentare laconicamente d’istinto: “Ah! Sei rimasta vittima del ‘censor bot’…”

Comprensibilmente, ricevo in risposta un sonoro ed acuto: “EH???”

Più che comprensibilmente, aggiungerei.

Come può un essere umano comprendere, attendersi, accettare, di essere “giudicato” da una “macchina”? Ed ancor peggio, come è possibile usare una “macchina” tanto “ignorante” (per quanto ciò possa aver senso in un sistema artificiale) – “l’algoritmo” – da non essere in grado nemmeno di evincere dal contesto la motivazione dell’uso di un termine?

Una macchina non potrà mai comprendere appieno le sfumature linguistiche, l’ironia, giungere alla finezza del gusto estetico od all’ampiezza della creatività umana. E per fortuna!

Ciononostante, qualche “umano”, ha “deciso” che “l’algoritmo” abbia facoltà di “giudicarci”.

Ciononostante, META ritiene che tale atteggiamento verso i propri utenti (sì, proprio coloro che usando i social del gruppo contribuiscano alla sua crescita) sia “legittimo”.

L’essere umano rappresenta l’unicum all’interno del sistema causa – effetto che governa la natura, agisce non ubbidendo meccanicamente a leggi fisiche, bensì per cognizione ed attraverso l’esplicitazione della propria volontà. È in grado di attuare processi costruttivi e distruttivi, di operare con consapevolezza le proprie scelte.

E META?

[1] Dott.ssa in Scienze Internazionali Diplomatiche, Master in “Religioni e Mediazione culturale” e Master in “Antiterrorismo Internazionale”. Esperienze formative maturate presso Radio Vaticana e la Camera dei Deputati