Guerra algoritmica

Come l’IA sta rivoluzionando le strategie militari

Un cambio di paradigma silenzioso ma radicale

Nel XXI secolo, la guerra non è più esclusivamente il dominio di carri armati, fanteria o testate nucleari; sta emergendo una nuova forma di conflitto, meno visibile ma non per questo meno letale: la guerra algoritmica. In essa, l’intelligenza artificiale (IA) non è solo uno strumento operativo, ma un attore strategico a pieno titolo: i software intelligenti elaborano informazioni, prendono decisioni, individuano obiettivi e, in alcuni casi, agiscono in autonomia, spesso in tempi incompatibili con l’intervento umano.

Una trasformazione dalle conseguenze profonde: sta modificando le dottrine militari, alterando gli equilibri di potere tra le grandi potenze, e ponendo nuove ed urgenti questioni etiche e giuridiche. È un cambiamento sistemico, paragonabile alle grandi rivoluzioni militari del passato: dalla meccanizzazione della Prima guerra mondiale all’introduzione dell’arma nucleare nella Guerra Fredda. Ma con una differenza sostanziale: l’IA non trasforma solo la potenza di fuoco, ma la capacità cognitiva e decisionale stessa delle forze armate.

Cos’è la guerra algoritmica?

Il concetto di “guerra algoritmica” si riferisce all’impiego sistemico di algoritmi di IA in tutti gli aspetti della condotta militare, dall’analisi informativa alla pianificazione operativa, fino all’impiego diretto di sistemi d’arma autonomi. Non si tratta solo dell’uso di IA come strumento di supporto, ma della sua integrazione nel ciclo decisionale bellico.

Tra le sue caratteristiche principali:

- Velocità decisionale senza precedenti: algoritmi in grado di analizzare scenari complessi e proporre (od eseguire) soluzioni tattiche in tempo reale.

- Automazione della letalità: l’impiego di sistemi d’arma autonomi, come droni o robot terrestri, capaci di identificare ed ingaggiare obiettivi senza supervisione umana continua.

- Capacità predittive avanzate: l’uso di big data e machine learning per anticipare mosse nemiche, prevedere scenari di crisi ed orientare le scelte strategiche.

- Diffusione su scala multi-dominio: l’IA opera simultaneamente nei cinque domini bellici tradizionali (terra, aria, mare, spazio, cyberspazio), interconnettendoli.

La guerra algoritmica non sostituisce l’uomo, ma lo affianca o addirittura lo precede nei tempi e nella logica dell’azione. Ciò porta con sé una tensione strutturale: l’esigenza di mantenere il controllo umano sulle decisioni di vita e di morte si scontra con l’efficienza superiore delle macchine in contesti ad alta intensità informativa.

Evoluzione storica: dal supporto decisionale all’autonomia operativa

L’introduzione dell’IA in ambito militare non è improvvisa: i primi sistemi informatici a supporto delle decisioni belliche risalgono agli anni ’60, con progetti come SAGE (Semi-Automatic Ground Environment), sviluppato dagli Stati Uniti per la difesa aerea durante la Guerra Fredda. Tuttavia, è negli anni 2000 che, con l’avvento del machine learning e dei big data, si assiste ad una vera discontinuità.

Negli Stati Uniti, lo spartiacque è rappresentato da Project Maven (2017), iniziativa del Dipartimento della Difesa volta ad utilizzare l’IA per analizzare le immagini satellitari ed i filmati dei droni, riducendo il carico cognitivo sugli analisti ed accelerando l’identificazione di obiettivi sospetti. Il successo del progetto ha aperto la strada ad una serie di altri programmi incentrati sull’automazione del ciclo di targeting (individuazione ed acquisizione degli obbiettivi).

Parallelamente, la Cina ha lanciato nel 2017 il suo Piano Nazionale per lo Sviluppo dell’Intelligenza Artificiale, con l’obiettivo dichiarato di diventare leader mondiale dell’IA entro il 2030. In ambito militare, ciò si traduce in un’alleanza stretta tra industria hi-tech e Forze Armate, con applicazioni che spaziano dalla guerra elettronica ai sistemi d’arma autonomi, come i droni intelligenti Wing Loong II.

Anche la Russia sta investendo sull’automazione militare, sebbene con un approccio più centrato su applicazioni asimmetriche, come la guerra ibrida e l’integrazione dell’IA nella disinformazione e nella guerra cognitiva.

Applicazioni operative dell’Intelligenza Artificiale nei conflitti moderni

L’Intelligenza Artificiale ha già dimostrato la sua efficacia in diversi scenari operativi: dai conflitti a bassa intensità alle operazioni ad alta tecnologia, l’IA è sempre più presente nei sistemi di comando e controllo, nella gestione delle informazioni e nella letalità di precisione.

Sistemi d’arma autonomi e semi-autonomi

Tra le applicazioni più controverse e potenti vi sono i sistemi d’arma letali autonomi (LAWS). Questi strumenti sono in grado di operare in ambiente ostile senza controllo umano diretto, una volta ricevute le regole d’ingaggio.

Un esempio emblematico è il drone Kargu-2, prodotto dall’industria turca STM. Secondo un rapporto delle Nazioni Unite, nel 2020 un Kargu-2 avrebbe ingaggiato ed ucciso un bersaglio umano in Libia senza comando diretto, in un’azione che rappresenterebbe il primo caso documentato di attacco autonomo letale da parte di un drone. Equipaggiato con algoritmi di riconoscimento facciale e targeting, il Kargu-2 opera in sciami coordinati, aumentando la capacità di saturazione del campo di battaglia.

Gli Stati Uniti, attraverso progetti DARPA come OFFSET (Offensive Swarm-Enabled Tactics), stanno sviluppando sciami autonomi di droni terrestri ed aerei, pensati per ambienti urbani complessi e missioni ad alto rischio. In Cina, aziende come Ziyan hanno testato droni intelligenti capaci di operare in gruppo, con apprendimento adattivo e comportamento coordinato.

Sorveglianza e superiorità informativa

L’IA è fondamentale per l’analisi e l’interpretazione di immagini satellitari, dati SIGINT (signal intelligence), OSINT (open source) e HUMINT (human intelligence). In ambito ISR (Intelligence, Surveillance, Reconnaissance), i sistemi IA permettono di:

- Identificare pattern sospetti in tempo reale;

- Riconoscere oggetti, veicoli e strutture in ambienti ostili;

- Monitorare aree vaste senza soluzione di continuità, riducendo l’impiego umano.

Il già citato Project Maven ha dimostrato come l’IA possa analizzare più rapidamente ed efficacemente i flussi video provenienti dai droni in operazioni di controterrorismo in Medio Oriente. Grazie al deep learning, l’algoritmo è in grado di differenziare un camion civile da un veicolo militare, o di riconoscere un fucile d’assalto in mano ad un individuo.

Nel teatro indo-pacifico, il PLA (Esercito Popolare di Liberazione) cinese utilizza reti neurali per la gestione predittiva del traffico marittimo ed aereo, incrociando dati civili e militari per anticipare movimenti strategici degli avversari.

IA nei sistemi C4ISR e nel comando distribuito

La vera forza dell’IA si manifesta nel comando e controllo distribuiti. I moderni sistemi C4ISR (Command, Control, Communications, Computers, Intelligence, Surveillance and Reconnaissance) stanno integrando algoritmi capaci di:

- Generare in tempo reale una mappa operativa comune (Common Operational Picture);

- Elaborare alternative strategiche su base probabilistica;

- Ricalibrare i piani operativi in funzione degli eventi sul campo.

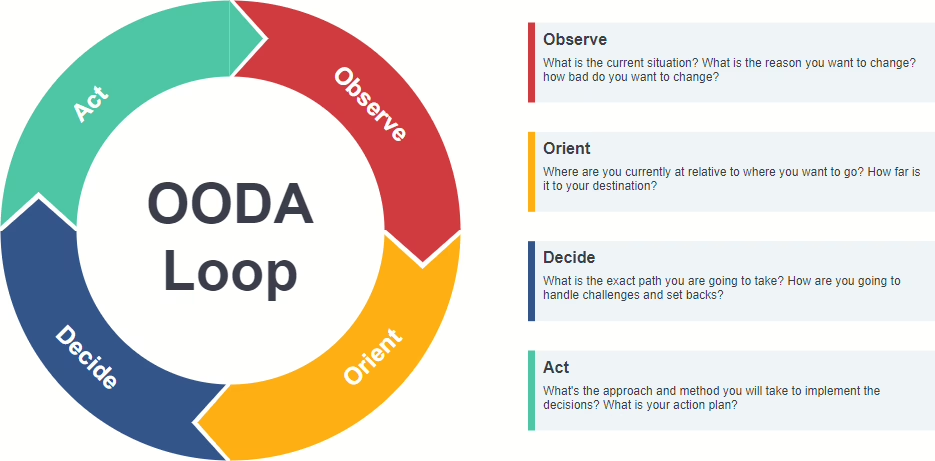

Progetti come l’Advanced Battle Management System (ABMS) dell’US Air Force mirano a connettere sensori, piattaforme e comandi attraverso l’IA, per consentire decisioni rapide e distribuite su più livelli gerarchici, riducendo drasticamente il ciclo OODA.

L’obiettivo è superare la rigidità della catena di comando tradizionale, favorendo una decisione decentralizzata basata su dati in tempo reale.

Supremazia algoritmica e dominio cognitivo

Oltre la superiorità cinetica: il vantaggio cognitivo

Nel contesto della guerra algoritmica, il possesso di carri armati o velivoli di quinta generazione non basta più. Il nuovo terreno della competizione è il dominio cognitivo, ossia la capacità di acquisire, processare e utilizzare informazioni più velocemente e con maggiore efficacia del nemico. È qui che l’IA si impone come fattore dirompente.

Il concetto di superiorità algoritmica implica il controllo della velocità del conflitto, attraverso:

- Capacità di prevedere ed anticipare le mosse avversarie;

- Riduzione drastica del tempo decisionale;

- Uso dell’IA per generare ambiguità informativa nel nemico, disorientandone il processo decisionale.

Nel contesto dottrinale, questo si traduce nella cosiddetta “accelerazione del ciclo OODA” (Osserva, Orienta, Decidi, Agisci), concettualizzato dal colonnello John Boyd. L’IA consente di “chiudere” questo ciclo in millisecondi, superando le capacità cognitive umane. Il rischio è che l’uomo venga escluso dal processo decisionale in tempo reale, lasciando l’iniziativa ad entità artificiali.

Guerra cognitiva e disinformazione automatizzata

L’IA non solo agisce sul piano cinetico od informativo, ma entra anche nella dimensione psicologica del conflitto. Attraverso tecnologie come il Natural Language Processing e le reti neurali generative (come GPT o sistemi simili sviluppati in contesti militari), stati, gruppi od anche singoli individui possono condurre campagne di disinformazione ad altissima efficacia.

Questa guerra cognitiva sfrutta i social network, la manipolazione dei flussi informativi, la creazione di contenuti falsificati (deepfake) e la saturazione informativa per indebolire la coesione interna di un paese, compromettere la fiducia nelle istituzioni ed alterare la percezione della realtà.

La Russia, in particolare, ha integrato questa dimensione nella sua dottrina di guerra ibrida, combinando operazioni cibernetiche, propaganda ed IA per alterare l’equilibrio informativo in teatri come Ucraina, Siria e Sahel.

Diritto, etica e limiti dell’autonomia militare

La sfida della responsabilità

Uno degli aspetti più controversi dell’impiego dell’IA in ambito militare riguarda la responsabilità legale. In caso di errore letale da parte di un sistema autonomo, chi risponde? Il comandante sul campo? Il produttore del software? Lo Stato utilizzatore?

Il diritto internazionale umanitario (DIU), fondato su principi come distinzione, proporzionalità e necessità, fatica ad adattarsi a contesti in cui l’agente decisionale non sia umano. Un sistema autonomo può distinguere in modo affidabile tra un combattente e un civile? È in grado di valutare il danno collaterale?

Organizzazioni come Human Rights Watch chiedono un divieto preventivo dei LAWS, promuovendo una campagna per mettere al bando le “armi completamente autonome”, sul modello della Convenzione di Ottawa sulle mine antiuomo. Altri attori, come gli Stati Uniti, preferiscono un approccio “etico per design”, basato sul principio del controllo umano significativo (Meaningful Human Control), ovvero, il mantenimento della supremazia decisionale umana.

Sovranità tecnologica e dominio strategico

Infine, la questione della guerra algoritmica è strettamente legata alla sovranità tecnologica: Le potenze che dominano lo sviluppo di IA militare (Stati Uniti, Cina, Russia) acquisiscono un vantaggio strategico duraturo non solo sul campo di battaglia, ma nella ridefinizione stessa delle regole della guerra.

L’Unione Europea si trova in una posizione intermedia: se da un lato promuove la ricerca comune attraverso iniziative come il Fondo Europeo per la Difesa e progetti come ASCEND (Autonomous Swarm Combat Edge), dall’altro impone paletti etici stringenti, che rischiano di rallentarne l’autonomia strategica rispetto agli attori globali.

Scenari futuri: deterrenza algoritmica e conflitto macchina-macchina

Verso conflitti a velocità superumana

Nel prossimo decennio, potremmo assistere alla nascita di conflitti dove la componente umana sarà progressivamente marginale, soprattutto nei momenti decisivi dell’azione militare. Sistemi d’arma autonomi e piattaforme IA interconnesse condurranno ingaggi in tempi incompatibili con la reazione umana, in una sorta di “machine-speed warfare”.

Questa accelerazione può produrre:

- Decisioni militari prese in millisecondi, senza consultazione politica;

- Reazioni a catena causate da equivoci tra IA, capaci di degenerare in escalation incontrollabili;

- La necessità di nuove forme di dissuasione: non più basate sulla minaccia nucleare, ma sulla deterrenza cognitiva ed algoritmica, dove la superiorità informativa e l’opacità delle capacità IA creano ambiguità strategica.

Un rischio concreto è l’effetto “black box”: i decisori politici potrebbero non comprendere appieno le motivazioni dietro le scelte operative suggerite dagli algoritmi, generando una crisi di fiducia o, peggio, l’automatizzazione dell’errore.

Dominio dell’intelligenza artificiale: confronto tra superpotenze

Il confronto strategico tra Stati Uniti, Cina e Russia si giocherà sempre più sul dominio dell’IA applicata alla sicurezza e alla difesa. Washington punta sulla centralità dell’ecosistema tecnologico privato e sulla modularità delle sue forze armate. Pechino integra verticalmente ricerca, industria e Forze Armate in un modello totalizzante, dove ogni innovazione civile può essere militarizzata. Mosca, pur con risorse limitate, scommette sull’IA per massimizzare l’efficacia delle operazioni asimmetriche ed ibride.

L’Europa e la sfida della sovranità algoritmica

L’Unione Europea si trova davanti a un bivio: da un lato ambisce ad una posizione autonoma e responsabile nell’uso dell’IA militare; dall’altro, rischia di restare schiacciata tra modelli operativi più aggressivi e meno vincolati da norme etiche. I progetti di cooperazione nel quadro della PESCO e del Fondo Europeo per la Difesa sono un primo passo, ma servono investimenti strutturali, standard comuni ed una visione strategica condivisa.

Una nuova dottrina per la guerra algoritmica

La guerra algoritmica non è una semplice evoluzione tecnologica, ma una rivoluzione cognitiva, operativa e dottrinale. Essa impone una revisione profonda delle categorie tradizionali:

- La distinzione tra tempo di pace e tempo di guerra tende a sfumare, vista la pervasività delle operazioni IA nel cyberspazio e nell’informazione.

- Il controllo dell’algoritmo diventa cruciale quanto il controllo dell’arma.

- Le decisioni strategiche si affidano sempre più a sistemi opachi, alimentando dilemmi etici e politici.

Per affrontare questa sfida è urgente:

- Definire un quadro normativo internazionale vincolante, che regoli l’uso dell’IA in guerra e limiti le armi autonome letali.

- Sviluppare dottrine militari aggiornate, che integrino la velocità e l’opacità degli algoritmi senza rinunciare al controllo umano.

- Promuovere una cultura strategica della responsabilità algoritmica, che coniughi innovazione e sicurezza collettiva.

In definitiva, la guerra algoritmica non è un futuro ipotetico, ma una realtà in rapida espansione. Ignorarla equivale a consegnare il campo di battaglia — e forse il destino delle decisioni vitali per i governi — a entità non umane. Comprenderla, governarla e normarla è la sfida strategica del nostro tempo.

Riferimenti bibliografici:

Project Maven e l’adozione dell’IA nel targeting militare

- Department of Defense. (2017, July 21). Project Maven to Deploy Computer Algorithms to War Zone by Year’s End. Defense.gov.

https://www.defense.gov/News/News-Stories/Article/Article/1254719/project-maven-to-deploy-computer-algorithms-to-war-zone-by-years-end/ - Center for a New American Security. (2018). Project Maven Brings AI to the Fight Against ISIS.

https://www.cnas.org/publications/commentary/project-maven-brings-ai-to-the-fight-against-isis

Kargu-2 e il primo attacco autonomo documentato

- Autonomous Weapon Systems

https://casebook.icrc.org/case-study/autonomous-weapon-systems - Hernandez, J. (2021, June 1). A Military Drone With A Mind Of Its Own Was Used In Combat, U.N. Says. NPR.

https://www.npr.org/2021/06/01/1002196245/a-u-n-report-suggests-libya-saw-the-first-battlefield-killing-by-an-autonomous-d

OFFSET: sciami autonomi per il combattimento urbano

- Defense Advanced Research Projects Agency. (n.d.). OFFensive Swarm-Enabled Tactics (OFFSET).

https://www.darpa.mil/research/programs/offensive-swarm-enabled-tactics - Defense Systems Information Analysis Center. (2024). DARPA OFFSET: Autonomous Drone Swarms for Warfighters.

https://dsiac.dtic.mil/articles/darpa-offset-autonomous-drone-swarms-for-warfighters/

ABMS e comando distribuito basato su IA

- Air Force Life Cycle Management Center. (2024, May 31). AFLCMC Leadership Log Episode 113: Advanced Battle Management System Overview [Video]. DVIDS.

https://www.dvidshub.net/video/925722/aflcmc-leadership-log-episode-113-advanced-battle-management-system-overview - Air Force Materiel Command. (2025). Advanced Battle Management System: Victory Through Distributed Connectivity.

https://www.afmc.af.mil/News/Article-Display/Article/4137120/advanced-battle-management-system-victory-through-distributed-connectivity/

Dilemmi etici e legali delle armi autonome

- Human Rights Watch. (2025, May 21). UN: Start Talks on Treaty to Ban ‘Killer Robots’.

https://www.hrw.org/news/2025/05/21/un-start-talks-treaty-ban-killer-robots - Human Rights Watch. (2020, August 10). Stopping Killer Robots: Country Positions on Banning Fully Autonomous Weapons and Retaining Human Control.

https://www.hrw.org/report/2020/08/10/stopping-killer-robots/country-positions-banning-fully-autonomous-weapons-and

Supremazia algoritmica e guerra cognitiva

- Kallenborn, Z. (2021, May 27). Was a Flying Killer Robot Used in Libya? Quite Possibly. Bulletin of the Atomic Scientists.

https://thebulletin.org/2021/05/was-a-flying-killer-robot-used-in-libya-quite-possibly/ - IEEE Spectrum. (2021, May 28). Lethal Autonomous Weapons Exist; They Must Be Banned.

https://spectrum.ieee.org/lethal-autonomous-weapons-exist-they-must-be-banned

Sovranità tecnologica e competizione tra superpotenze

- Defense Scoop. (2025, May 23). DOD and Air Force Continue to Define Joint Command and Control.

https://www.gao.gov/products/gao-23-105495 - SpaceNews. (2025, May 23). Pentagon Boosts Budget for Palantir’s AI Software in Major Expansion of Project Maven.

https://spacenews.com/pentagon-boosts-budget-for-palantirs-ai-software-in-major-expansion-of-project-maven/